https://www.mk.co.kr/news/it/11921190

“수학 문제에서 중요한 것은 순서입니다. 사칙연산 순서를 알고 있나요?”

아이가 인공지능(AI)에 왜 수학 문제를 틀렸는지 묻자, AI는 답변 대신 질문을 던진다. 소크라테스식 대화법을 구현한 AI 튜터 ‘칸미고’의 모습이다. 칸아카데미가 오픈AI 최신 모델을 기반으로 개발한 이 프로그램은 단순한 대화 수준을 넘어 교육 패러다임을 바꾸고 있다.

최근 에듀테크의 화두는 ‘멀티모달’ 기능이다. 최신 AI 튜터들은 학생의 목소리 톤과 표정, 심지어 문제를 풀 때의 망설임까지 실시간으로 분석한다. 학생이 문제를 풀다 인상을 찌푸리면 AI는 “지금 이 부분이 조금 어렵게 느껴지나 보네. 같이 천천히 다시 해볼까”라며 응원과 함께 문제풀이 힌트를 준다.

과학교육도 진화하고 있다. ‘생성형 AI 기반 동적 가상 실험실’이 대표적인 사례다. 과거 막대한 예산이 들거나 위험했던 화학·물리 실험을 AI가 생성한 정교한 가상현실(VR) 환경에서 수행한다. 학생들은 AI 안내에 따라 분자 구조를 직접 손으로 조작하거나 행성 간 중력을 시뮬레이션하는 경험을 하며 원리를 깨우친다.

교사의 업무도 본질적 변화를 맞이했다. 월스트리트저널 보도에 따르면 지난해 미국 내 주요 교육청은 ‘매직스쿨’과 같은 교사 전용 AI 코파일럿 채택을 전년 대비 3배 이상 늘렸다. 교사들은 AI를 활용해 학생 수백 명에 대한 맞춤형 수업 계획을 몇 분 만에 생성한다. 역사 수업 중에는 에이브러햄 링컨 대통령을 가상세계로 소환해 학생들과 실시간 토론을 벌인다.

주목할 만한 대목은 이 같은 기술적 진보가 전통적 학교의 담장까지 허물고 있다는 점이다. AI가 정교한 학습 설계와 행정 업무를 지원하면서 소규모 공동체 학교인 ‘마이크로스쿨’이나 홈스쿨링을 선택하는 가정이 세계적으로 늘고 있다. 특히 AI 튜터로 핵심 교과 학습을 효율화하고, 남은 시간은 창의적 프로젝트에 할애하는 모델이 대안교육의 주류로 부상하는 추세다.

각국 정부는 AI 교육을 국가 경쟁력의 핵심으로 보고 과감한 투자를 이어가고 있다. 중국은 작년 9월부터 초등학교부터 AI 교육을 의무화했다. 동시에 저소득층 학생 100만명에게는 고성능 AI 학습 단말기를 보급해 교육 격차 해소에도 활용하고 있다. 싱가포르도 모든 초·중등 학생에게 맞춤형 AI 튜터 시스템을 보급했다. 아랍에미리트(UAE)는 세계 최초의 AI 전문대학(MBZUAI)을 중심으로 유치원부터 고교까지 AI를 필수과목으로 지정해 ‘AI 네이티브’ 세대를 육성 중이다.

반면 ‘세계 최초’를 내걸었던 한국의 AI 디지털교과서(AIDT)는 도입 과정부터 진통을 겪은 끝에 활용률이 8%대에 머물러 있다. 박남기 전 광주교대 총장은 “AI 앱을 활용하는 단계에서 ‘교과서’라는 용어에 집착해 불필요한 논쟁이 커진 측면이 있다”며 “학생들이 AI를 비판적으로 수용하는 리터러시 교육과, 교사들이 현장에서 AI를 자유자재로 다룰 수 있는 실용적 연수에 역량을 집중해야 할 시점”이라고 강조했다.

'프로그래밍 > AI_DeepLearning' 카테고리의 다른 글

| 코딩 없이 배우는 프롬프트 엔지니어링: 누구나 할 수 있는 생성형 AI 활용법 (0) | 2025.10.02 |

|---|---|

| [AI] 5W1H를 활용한 프롬프트 설계 방법 📝 (0) | 2025.09.26 |

| AI 파일럿의 95%가 실패하는 이유 — 그리고 당신이 피하는 법 (every.to) (0) | 2025.09.15 |

| [AI] 오픈AI '10년 판짜기'의 여정 (0) | 2025.09.08 |

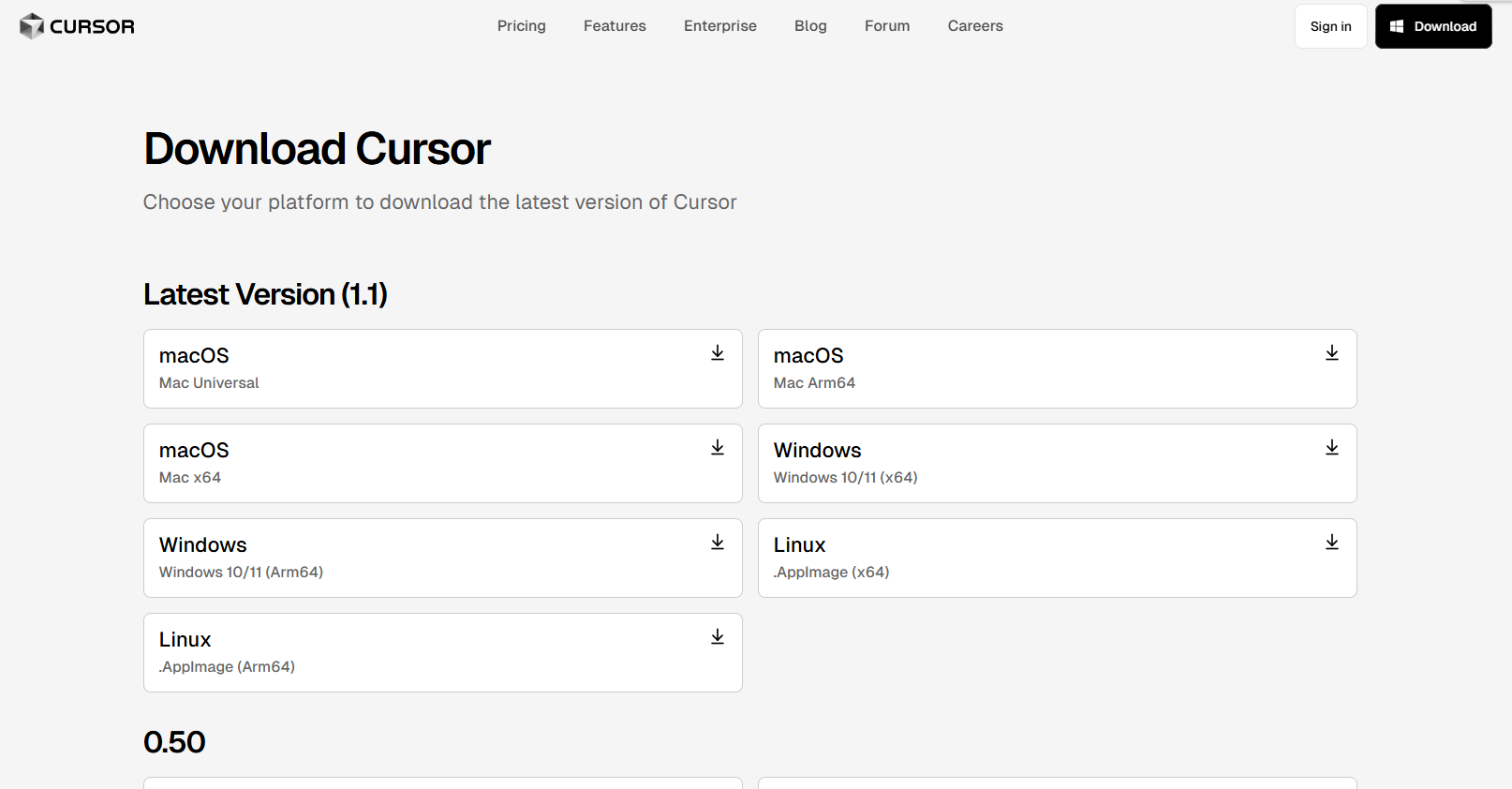

| [AI] 커서(Cursor)와 바이브코딩(Vibe Coding) (1) | 2025.07.04 |