Google 지도 서비스용 Python 클라이언트

파이썬을 사용합니까? 무언가를 지오코딩하고 싶습니까? 방향을 찾고 계십니까? 아마도 방향의 행렬일까요? 이 라이브러리는 Google Maps Platform 웹 서비스를 Python 애플리케이션에 제공합니다.

Google Maps Services용 Python 클라이언트는 다음 Google Maps API용 Python 클라이언트 라이브러리입니다.

- 길찾기 API

- 거리 행렬 API

- 고도 API

- 지오코딩 API

- 지리적 위치 API

- 시간대 API

- 도로 API

- 장소 API

- 지도 정적 API

- 주소 확인 API

요구 사항

- 파이썬 3.5 이상.

- Google 지도 API 키입니다.

API 키

각 Google 지도 웹 서비스 요청에는 API 키 또는 클라이언트 ID가 필요합니다. API 키는 Google Cloud Console 'API 및 서비스' 탭의 '사용자 인증 정보' 페이지에서 생성됩니다 .

Google Maps Platform 시작하기 및 API 키 생성/제한에 대한 자세한 내용은 Google 문서에서 Google Maps Platform 시작하기를 참조하세요.

중요: 이 키는 서버에서 비밀로 유지되어야 합니다.

설치

$ pip install -U googlemaps

연결/읽기 제한 시간을 지정하려면 요청 2.4.0 이상이 필요합니다.

https://pypi.org/project/googlemaps/

googlemaps

Python client library for Google Maps Platform

pypi.org

https://github.com/googlemaps/google-maps-services-python

GitHub - googlemaps/google-maps-services-python: Python client library for Google Maps API Web Services

Python client library for Google Maps API Web Services - GitHub - googlemaps/google-maps-services-python: Python client library for Google Maps API Web Services

github.com

'프로그래밍 > Python' 카테고리의 다른 글

| [python] Sorting-Algorithms-Visualizer (0) | 2023.05.26 |

|---|---|

| [python] Use Phone Camera with python (0) | 2023.05.24 |

| [Python] 현재 파일/디렉토리 위치 확인 및 변경 (0) | 2023.05.18 |

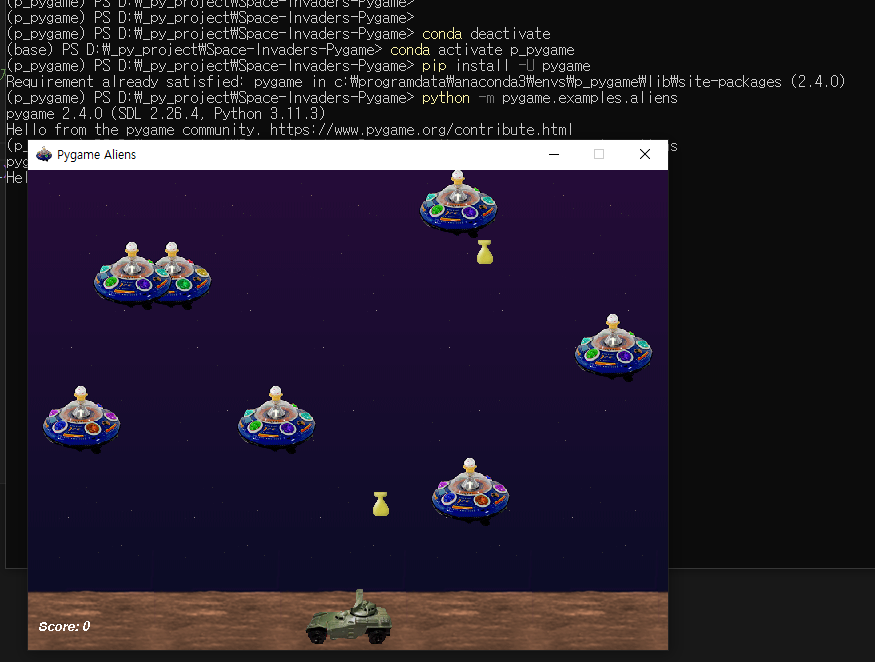

| [PYTHON] python에서 pygame 실행해보기 aliens - https://www.pygame.org/wiki/GettingStarted (0) | 2023.05.18 |

| [PYTHON] Visual Studio Code 설치 (0) | 2023.05.18 |