ai

- AI 시대 2025.12.08

- 프로그래머 정체성의 위기 2025.10.27

- 마인크래프트 하면서 영어 배운다…알레프랩 와이콤비네이터에 ‘낙점’ 2025.10.17

- “튜토리얼 지옥”을 대체한 “바이브 코딩 지옥”의 등장 2025.10.13

- 코딩 없이 배우는 프롬프트 엔지니어링: 누구나 할 수 있는 생성형 AI 활용법 2025.10.02

- [AI] 5W1H를 활용한 프롬프트 설계 방법 📝 2025.09.26

AI 시대

프로그래머 정체성의 위기

https://news.hada.io/topic?id=23845

프로그래머 정체성 위기 | GeekNews

프로그래머의 정체성이 최근 AI와 LLM 도구의 등장으로 위협받고 있음프로그래밍 문화는 1950년대 MIT의 해커 윤리에서 시작되어 코드 작성 그 자체를 깊이 있는 기술(craft)로 여기며, 정밀한 논리

news.hada.io

https://hojberg.xyz/the-programmer-identity-crisis/

- 프로그래머의 정체성이 최근 AI와 LLM 도구의 등장으로 위협받고 있음

- 프로그래밍 문화는 1950년대 MIT의 해커 윤리에서 시작되어 코드 작성 그 자체를 깊이 있는 기술(craft)로 여기며, 정밀한 논리와 문제 해결의 몰입을 핵심 가치로 삼아왔음

- 그러나 현재 AI 산업과 LLM 도구들은 개발자를 단순 명세 작성자나 오퍼레이터로 전환시키려 하며, 직접 코드를 작성하는 대신 자연어로 지시만 내리는 "vibe-coding" 방식을 강요하고 있음

- LLM 생성 코드는 비결정적이고 부정확하며, 개발자가 직접 코드를 읽고 작성하는 과정에서 얻는 깊은 이해와 몰입을 제거하여 코드베이스와의 연결을 단절시킴

- 기업들은 생산성 증대를 명분으로 도구 사용을 강제하고, 팀 내 협업과 멘토링 문화를 AI와의 상호작용으로 대체하면서 개발자 간 인간적 연결을 약화시키고 있음

- 프로그래밍을 단순 산출물이 아닌 사고와 이해의 과정으로 보는 본질적 가치가 상실되고 있으며, 개발자들은 자신의 기술과 즐거움, 그리고 직업적 정체성을 지키기 위해 이러한 변화에 저항해야 함

프로그래머의 본질과 전통

- 코드 작성은 단순한 업무가 아니라 개발자의 정체성 그 자체이며, 에디터는 작업장이자 성소로서 기술을 연마하고 몰입 상태(flow)에 들어가는 공간임

- Vim과 같은 도구를 통해 생각과 코드 사이의 장벽 없이 작업하며, 현실 세계에 영향을 미치는 비물질적 세계를 창조함

- 퍼즐을 푸는 과정 자체가 완성된 그림보다 중요하며, 손가락에서 버퍼로 이어지는 기술의 흐름 속에서 시간이 사라짐

- 1950년대 후반 MIT에서 새로운 프로그래밍 문화가 탄생했으며, 실험적이고 반체제적인 성향을 가진 해커들이 Flexowriter와 TX-0 컴퓨터를 사용하며 완벽한 프로그램을 추구함

- "The Right Thing"이라는 개념을 중심으로 우아하고 간결한 코드를 작성하는 것을 목표로 삼음

- Tech Model Railroad Club 멤버들은 기계 언어에 몰두하며 디지털 마법을 익혔고, 발견한 지식을 다른 학생들과 공유하는 문화를 확립함

- Building 26의 컴퓨팅 도가니에서 코딩 기술이 단련되었으며, 약 70년 전 확립된 이 문화는 현재까지 이어져 개발자들의 마음과 기계에 여전히 존재함

- 고대 해커들의 유산은 깊고 운동적인 기술로 남아있으며, 이를 기반으로 열정적인 산업이 구축됨

- 개발자들은 여전히 동일한 경이로움, 성취감, 퍼즐 해결의 우아함에 의해 동기부여되고 있음

- 그러나 프로그래머의 정체성을 구성하는 이러한 핵심 가치들이 위협받고 있으며, 한때 밝고 명확했던 프로그래밍의 미래가 이제는 불길한 어둠과 사기, 불확실성으로 가려져 있음

AI 산업의 새로운 정체성 강요

- 수십억 달러 규모의 AI 산업, Hacker News 커뮤니티, LinkedIn의 LLM 지지자들은 소프트웨어 개발의 미래가 프로그래밍과 거의 닮지 않았다고 주장하며, 1년 전 밈처럼 보였던 "vibe-coding"이 주류가 되고 있음

- 개발자들은 코드 대신 Markdown으로 명세를 작성해야 하며, 코드베이스의 구석구석을 탐험하고 퍼즐을 풀며 비밀을 발견하는 깊은 몰입과 기술의 깊이가 사라짐

- 대신 개발자를 위해 에이전트들이 사고하는 동안, 산만한 인지와 컨텍스트 스위칭을 받아들여야 하며, 창의적 문제 해결은 기계에 맡기고 개발자는 단순 오퍼레이터가 됨

- 일부 개발자들은 이러한 변화와 "Specification Engineering"이라는 새로운 정체성을 환영하며, 오퍼레이터가 되어 Steve Jobs처럼 "오케스트라를 지휘"하는 것에 흥분함

- 코딩에 대한 관심이 없는 것으로 보이는데도 왜 프로그래머가 되었는지 의문이며, Woz와 Jobs를 혼동한 것이 아닌가 생각됨

- Prompt, Context, Specification "Engineering"이 프로그래머에게 밝고 번영하는 직업을 가져다줄 것으로 보이지 않음

- 이는 기술, 숙련도, 노동의 가치 하락을 의미하며, 개발자의 고유한 추상적 사고 능력이 더 이상 필요하지 않은 영역으로 이동하여 이미 제품 매니저와 디자이너가 차지하고 있는 공간으로 들어가게 됨

기업 내 권력 역학의 변화

- 기업 내에서 이 새로운 정체성이 강요되면서 권력 역학이 변화하고 있으며, 잘못된 곳에서 생산성을 높이려는 광적인 시도로 개발자들은 점점 더 구체적인 방식으로 LLM을 사용하도록 강제됨

- 순응하지 않으면 쫓겨나고, 자신의 쓸모없음을 알리는 제품을 사용하거나 사직해야 함

- 과거에는 경영진이 개발자의 도구를 이렇게 구체적으로 지시한 적이 거의 없었음

- 개발자들은 셰프나 목수처럼 자신의 도구를 큐레이팅하고 연마하는 데 큰 자부심을 가져왔으며, 에디터의 세심한 설정, 닷 파일 조정, 개발 환경 구성 등을 통해 자신의 사고방식에 맞게 도구를 개인화해왔음

- 기술의 일부로서 도구 세트를 개인화하는 데 헌신해왔으나, 일상 업무와 거의 연결되지 않은 경영진이 이를 명령하는 것은 침해처럼 느껴짐

- 수십 년간 기업 내에서 우대받았던 프로그래머들에게, 이러한 내러티브는 경영진이 균형을 다시 자신들에게 유리하게 기울일 새로운 방법을 제공함

LLM과 프로그래밍 언어의 본질적 차이

- 일부는 LLM의 영향을 저수준 언어에서 고수준 언어로의 전환에 비유하지만(Assembly에서 Fortran으로), 이는 여러 측면에서 잘못된 비유임

- Fortran은 프로그래밍에 뿌리를 두고 기술을 제거하려 하지 않고 그 위에 구축했으며, 프로그래밍의 정밀성과 표현력을 제거하지 않고 확장함

- Fortran은 입력에 대해 항상 올바른 결과를 성공적으로 생성했지만, LLM의 세계에서는 이 중 어느 것도 사실이 아님

- 컴퓨터와 프로그래밍은 매우 좌절스러울 수 있지만, 적어도 정밀성에 대해서는 항상 신뢰할 수 있었으며, 프로그래밍을 통해 지시한 대로 정확히 수행함

- 컴퓨터의 정밀성에 대한 의존과 신뢰 때문에, 챗봇이 요청한 작업을 수행했다고 가스라이팅할 때 이를 믿기 쉬움

- LLM과 그 작업은 본질적으로 부정확하며, 대형 언어 모델의 속성과 자연어로 지시하는 방식 모두에서 오해의 여지가 있음

- 비결정성을 싫어하는 프로그래머들이 이러한 접근 방식을 선택한 것은 흥미로우며, 예측 가능성, 조합성, 멱등성, 불안정하지 않은 통합 테스트를 선호함

- LLM 코드는 그 반대인 일관성 없는 혼돈을 나타냄

- Dijkstra는 "자연어 프로그래밍의 어리석음에 대하여"에서 자연어가 작업을 단순화할 것이라는 가정에 도전해야 한다고 지적했으며, 형식적 텍스트의 장점은 합법적이기 위해 몇 가지 간단한 규칙만 충족하면 된다는 점이라고 강조함

깊은 이해와 몰입의 상실

- AI 보조 개발을 엄격함과 관료주의로 vibe-coding과 구분하려는 움직임이 있지만, 이는 근본적인 본질을 무시함

- LLM이 생성한 코드를 자신이 작성했거나 PR에서 리뷰했을 때만큼 면밀히 읽지 않게 되며, LLM 코딩에는 눈을 멍하게 만드는 본질적인 무언가가 있음

- 대충 훑어보게 되고 압도당하고 지루해하며, CI가 통과하고 프로그램이 컴파일되면 위험한 함정을 맹목적으로 받아들임

- 테스트가 실행되도록 설정되었는지, 존재하지 않는 라이브러리를 가져왔는지, 전체 라이브러리를 스스로 구현했는지 확인하지 않음

- 책의 리뷰나 요약은 직접 읽는 경험을 대체할 수 없으며, 수백 페이지에 걸쳐 각 문장을 신중하게 소비하며 아이디어를 숙고하는 과정이 필요함

- 마찬가지로 AI가 완료한 작업의 요약을 훑어보는 것은 도메인, 문제, 가능한 솔루션에 대한 깊은 이해를 형성하는 것을 빼앗으며, 코드베이스와의 연결을 차단함

- 무지의 심연에 뛰어들어 주제와 그 함의를 드러내고 배우고 이해하는 것은 만족스럽고 좋은 소프트웨어에 필수적임

- 소유권, 주체성, 깊고 만족스러운 작업은 에이전트 탭 사이의 산만한 주의로 대체됨

- Joan Didion은 "나는 내가 무엇을 생각하고 있는지, 무엇을 보고 있는지, 무엇을 보고 그것이 무엇을 의미하는지 알아내기 위해 글을 쓴다"고 말했으며, Peter Naur는 "Theory Building으로서의 프로그래밍"에서 동일한 개념을 탐구함

- Naur의 "Theory"는 코드베이스의 이해를 구현하며, 작동 방식, 형식주의, 현실 세계의 표현을 포함함

- 이러한 맥락과 통찰은 오직 몰입을 통해서만 얻어지며, Naur는 "Theory"를 소프트웨어보다 프로그래밍의 주요 결과물이자 실제 제품으로 설명함

- 잘 발달된 "Theory"가 있어야만 코드베이스에 확장과 버그 수정을 효과적으로 적용할 수 있음

- 좋은 디자인은 몰입에서 나오며, 텍스트 버퍼에서의 왔다 갔다 하는 작업과 종종 키보드에서 떨어진 곳에서의 작업을 통해 나타남

- 전체 코드베이스를 마음속에 담을 수 없기에, 모듈, 클래스, 함수에 뛰어들어 흐릿한 정신 모델을 선명하게 해야 함

- 코드를 읽고 작성하여 인지를 확장하고, 익숙함과 문제 도메인에 대한 이해를 회복해야 함

- 맥락의 일부가 구축되고 많은 부족한 시도를 통해 마침내 해결책을 발견할 수 있으며, 나쁜 디자인의 불협화음을 느껴야 함

- 혐오스럽고 반복적인 코드를 작성할 때만 더 나은, 더 간결하고 우아하며 조합적이고 재사용 가능한 방법이 있다는 것을 깨달음

- 이는 문제에 대해 깊이 생각하기 위해 멈추게 하고, 한 걸음 물러서서 처음부터 다시 시작하게 함

- 반대로 AI 에이전트 작업은 마찰이 없어 대안적 솔루션을 피하게 되며, 수락하는 것이 완벽한지, 평범한지, 끔찍한지, 심지어 해로운지 알 수 없음

팀 협업과 인간 연결의 붕괴

- LLM 중심 코딩의 인지적 부채는 기술 이탈을 넘어 확장되며, 주의 집중 시간이 짧은 "slop-jockey"들이 풀 리퀘스트와 디자인 문서에 자신의 작업물을 던지며 협업을 저해하고 팀을 방해함

- 코드 리뷰를 하는 동료들은 자신이 이제 마지막 품질 관리 레이어가 아니라 첫 번째 레이어라는 충격적인 깨달음에 정신을 잃어가고 있음

- 새로 추가되었지만 호출되지 않는 함수, 환각된 라이브러리 추가, 명백한 런타임 또는 컴파일 오류를 지적해야 함

- 자신의 코드를 명백히 훑어보기만 한 작성자는 책임을 지지 않으며, "Claude가 그렇게 작성했어요. 바보 같은 AI, 하하"라고 말함

- 간섭하는 관리자와 돈을 아끼려는 임원들은 팀에서 인간 상호작용을 줄이도록 (희망컨대 무의식적으로) 압박하고 있음

- 고립되고 연결이 박탈된 상태에서, 이제 작업 경험 주위에 벽을 쌓도록 권한을 부여받고 장려됨

- 페어 프로그래머가 필요하거나, 솔루션을 주고받으며 논의하거나, 프로토타입을 만들거나, 아키텍처를 스케치하거나, 코드베이스의 난해한 부분에 대한 전문가 질문에 답하는 데 도움이 필요할 때 사람 대신 LLM에 의존함

- 더 이상 온보딩 버디, 멘토, 동료가 필요하지 않으며, 대신 기계와 대화할 수 있음

- LLM으로 인간 접촉을 피하는 것이 너무 쉬워져 이것이 표준이 될 수 있음

프로그래머 정체성의 방어

- 우리가 AI 과대광고 내러티브에 얼마나 순응적이며, 기술의 계획된 삭제에 적극적으로 참여하고, 사고 수단을 기꺼이 포기하는지가 충격적임

- 취미로 생계를 꾸릴 수 있었던 행운아들이었는데, 슬롭에 대응하기 위해 엄격하고 꼼꼼한 프로세스를 만들더라도 여전히 일의 재미있는 부분을 아웃소싱하고 이를 지시적 고역으로 대체한 것임

- LLM은 소프트웨어의 복잡성에 대한 궤도에서 핵폭탄을 투하하는 솔루션처럼 보이며, 실제 문제를 해결하는 대신 증상을 치료하기 위해 훨씬 더 복잡하고 모호한 것에 손을 뻗음

- sed를 Claude로 대체하거나, 문서를 수 시간 동안 검색한 후에도 명확성을 찾는 라이브러리나 프레임워크에 대한 답변을 요청하는 것은 괜찮음

- 그러나 단순히 오퍼레이터나 코드 리뷰어가 되어 재미있고 흥미로운 작업에서 뒷자리를 차지하는 것은 원하지 않음

- 반복적인 작업을 돕고, 코드베이스를 이해하고, 올바른 프로그램을 작성하는 데 도움이 되는 도구를 선호하며, 나를 위해 생각하도록 설계된 제품에는 불쾌감을 느낌

- 내가 생산하는 소프트웨어에 대한 자신의 이해의 주체성을 제거하고, 동료와의 연결을 끊는 제품을 거부함

- LLM이 과대광고에 부응하더라도, 우리는 여전히 이 모든 것과 기술을 잃게 될 것임

- 인간은 기계와 그들을 지원하는 기업보다 중요하며, 나머지 우리가 그들이 판매하는 새로운 아메리칸 드림을 쫓는 동안 그들은 이익을 얻고 있음

- 대가로 우리는 비판적 사고 능력, 재미, 기술, 프라이버시, 그리고 아마도 지구를 제공하고 있음

'프로그래밍' 카테고리의 다른 글

| 삼성 인터넷을 PC에서 사용해 보세요! https://browser.samsung.com/beta (0) | 2025.11.27 |

|---|---|

| 데브옵스의 확장 모델 – 깃옵스(GitOps) 이해하기 (0) | 2025.11.25 |

| PHP 8.5: The Version That Will Actually Makes Life Easier (0) | 2025.10.17 |

| 마인크래프트 하면서 영어 배운다…알레프랩 와이콤비네이터에 ‘낙점’ (0) | 2025.10.17 |

| “튜토리얼 지옥”을 대체한 “바이브 코딩 지옥”의 등장 (0) | 2025.10.13 |

마인크래프트 하면서 영어 배운다…알레프랩 와이콤비네이터에 ‘낙점’

마인크래프트 하면서 영어 배운다…알레프랩 와이콤비네이터에 ‘낙점’

https://www.mk.co.kr/news/business/11443250

마인크래프트 하면서 영어 배운다…알레프랩 와이콤비네이터에 ‘낙점’ - 매일경제

게임형 AI 학습 에이전트 크루캐피탈이어 후속 투자 유치 게임·언어·과목 등 확장 계획

www.mk.co.kr

게임형 인공지능(AI) 스타트업 알레프 랩(Aleph Lab)이 미국 실리콘밸리 대표 스타트업 액셀러레이터인 와이콤비네이터(YC)에 낙점됐다.

알레프랩은 올해 가을(F25) 와이콤비네이터 배치 프로그램에 선정돼 후속 투자를 유치했다고 16일 밝혔다. 지난 8월 설립 직후 크루캐피탈(Krew Capital)로부터 첫 투자를 받은 지 약 한 달 만이다.

알레프 랩은 아이들이 좋아하는 게임을 통해 자연스럽게 영어를 습득하는 경험을 목표로, AI 원어민 친구와 함께 게임 마인크래프트 안에서 실시간으로 대화하며 영어를 배우는 학습 서비스 ‘알레프 키즈(Aleph Kids)’를 개발하고 있다. 연내에 게임 플랫폼 ‘로블록스’에서도 서비스를 지원할 계획이다.

알레프 키즈의 첫 번째 AI 원어민 친구 ‘애니’(Annie)는 단순한 대화형 챗봇이 아닌 AI 에이전트로, 주변 환경을 인식해 아이의 답변을 유도하는 질문을 생성하며 자연스러운 언어 학습을 설계했다.

학습자의 흥미, 언어 수준, 게임 상황을 실시간으로 분석해 맞춤형 학습 커리큘럼을 생성하고, 놀면서 배우는 경험(learn through play)을 제공하는 것이 목표다.

투자금은 이후 로블록스 등 인기 게임 속 AI 친구 출시, 스페인어와 프랑스어 등 언어 확장, 수학·과학 등 과목 추가, 성인 대상 학습 서비스 출시 등 제품 확장에 활용될 예정이다.

장한님·한관엽 공동대표는 “아이들이 값비싼 해외 영어캠프나 유학을 가지 않더라도, 언제 어디서나 AI 원어민 친구와 함께 놀면서 자연스럽게 영어 실력을 키우고 유창해질 수 있도록 하겠다”며 “아이들이 해외에 나가서 자신감 있게 영어로 대화하고, 학업과 커리어에서 더 많은 선택지를 가질 수 있는 세상을 만들 것”이라고 밝혔다.

'프로그래밍' 카테고리의 다른 글

| 프로그래머 정체성의 위기 (0) | 2025.10.27 |

|---|---|

| PHP 8.5: The Version That Will Actually Makes Life Easier (0) | 2025.10.17 |

| “튜토리얼 지옥”을 대체한 “바이브 코딩 지옥”의 등장 (0) | 2025.10.13 |

| 구글도 ‘어디서나 근무’ 이젠 안돼…회사로 나오라는 빅테크 (0) | 2025.10.13 |

| 왜 우리는 악순환에 빠지는가 (behavioralscientist.org) (0) | 2025.09.22 |

“튜토리얼 지옥”을 대체한 “바이브 코딩 지옥”의 등장

https://blog.boot.dev/education/vibe-coding-hell/

I'm in Vibe Coding Hell

When I started thinking about the problems with coding education in 2019, “tutorial hell” was enemy number one. You’d know you were living in it if you:

blog.boot.dev

https://news.hada.io/topic?id=23590

“튜토리얼 지옥”을 대체한 “바이브 코딩 지옥”의 등장 | GeekNews

최근 코딩 교육 환경에서 “튜토리얼 지옥” 대신 “바이브 코딩 지옥” 이 새로운 문제로 대두됨튜토리얼 지옥이 "튜토리얼 없이는 아무것도 만들지 못하는" 상태였다면, 바이브 코딩 지옥은 "

news.hada.io

- 최근 코딩 교육 환경에서 “튜토리얼 지옥” 대신 “바이브 코딩 지옥” 이 새로운 문제로 대두됨

- 튜토리얼 지옥이 "튜토리얼 없이는 아무것도 만들지 못하는" 상태였다면, 바이브 코딩 지옥은 "AI 없이는 코딩할 수 없고, AI가 생성한 코드가 어떻게 작동하는지 이해하지 못하는" 상태를 의미

- AI 도구의 과도한 사용이 학습 동기를 저하시키며, AI 리터러시가 낮은 사람일수록 AI를 더 많이 사용하는 역설적 상황이 발생하고 있음

- AI 도구는 적절하게 활용하면 학습 보조에 큰 도움이 될 수 있으나, 무작정 ‘답만 얻기’식 사용은 건설적 이해 형성에 방해가 됨

- 학습 과정에서 직접 고민하고 스스로 해결하려는 노력이 핵심, 튜토리얼·AI 보조 없이 문제 해결 경험을 쌓는 자세가 중요함

문제의 배경: 튜토리얼 지옥에서 바이브 코딩 지옥으로

- 2019년 당시 코딩 교육의 주요 문제는 "튜토리얼 지옥" 이었음

- 튜토리얼을 따라하는 데는 성공하지만 혼자서는 아무것도 만들지 못함

- 실제 프로그래밍보다 프로그래밍 관련 동영상 시청에 더 많은 시간을 소비하며, 핵심 개념은 이해하지 못함

- 결과적으로 피상적 지식만 쌓고, 내부 작동 원리는 이해하지 못해서 현실에서는 코드를 스스로 쓰지 못하는 상태

- Boot.dev는 이를 해결하기 위해 세 가지에 집중함

- 심층 커리큘럼: 전통 대학 외부에서도 CS 기초를 배울 필요성 강조

- 실습 중심 방식: 모든 개념 학습과 함께 코드를 직접 작성

- 비디오보다 리치 텍스트 강화: 비디오는 수동적 소비에 그칠 위험성 있음

- 2019년에는 수백만 조회수를 기록하던 긴 YouTube 강의들이 현재는 5만 조회수도 달성하기 어려움

- FreeCodeCamp, Traversy Media, Web Dev Simplified 등의 채널이 이러한 추세를 보임

- 그러나 "learn to code"에 대한 Google Trends 데이터는 여전히 높은 관심도를 유지하고 있음

- Boot.dev에 매일 약 1,300명의 신규 사용자가 등록하며, 최근 18개월간 튜토리얼 지옥에 대한 불만은 줄었지만 새로운 형태의 어려움이 나타남

바이브 코딩 지옥의 정의

- 튜토리얼 지옥의 특징

- "튜토리얼 없이는 아무것도 만들 수 없다"

- "문서를 이해하지 못하니 동영상이 필요하다"

- "간단한 작업에도 복잡한 프레임워크가 필요하다"

- 바이브 코딩 지옥의 특징

- "Cursor의 도움 없이는 아무것도 할 수 없다"

- "멋진 타워 디펜스 게임을 만들었어요. 여기 링크에요 http://localhost:3000";

- "이미지 lazy-load를 위해 Claude가 6,379줄을 추가한 이유를 모르겠어요"

- 현재 자기주도 학습자들은 많은 것을 만들고 있지만, 소프트웨어 작동 방식에 대한 멘탈 모델을 발전시키지 못하는 프로젝트를 구축함

- AI의 환각(hallucination)과 싸우고, 테스트 통과에만 집중하는 봇과 씨름하며 실제 문제 해결보다는 AI가 생성한 코드를 맹목적으로 신뢰함

AI 코딩의 미래와 현실

- 나는 단기적으로 AI가 개발자를 완전히 대체하지는 않을 것이라는 데 긍정적 입장

- "AI가 일자리를 빼앗을 때까지 6개월"이라는 말이 나온 지 3년이 지났지만 여전히 개발자를 고용하고 있음

- GPT-5가 출시되었지만 GPT-4 대비 점진적 개선에 그쳤으며, AGI가 곧 도래하지 않을 것임을 보여주는 증거로 해석됨

- 매일 AI 도구를 사용하지만 실제로 생산성이 얼마나 향상되는지 확신하지 못함

- AI가 더 생산적이게 만드는지, 아니면 더 게으르게 만드는지 불분명

- 2025년 연구 결과: 개발자들은 AI가 20-25% 생산성을 높인다고 가정했지만, 실제로는 19% 느려짐

- 7조 달러 투자 대비 실망스러운 결과

AI와 학습동기 저하의 위험성

- AI 활용 문화가 학습자의 동기 부여에 부정적일 수 있음

- AI 열풍(버블?)에서 가장 우려되는 점은 "왜 배워야 하나? AI가 다 알잖아"라는 태도를 가진 세대가 등장한다는 것

- AI가 실제로 모든 화이트칼라 직업을 대체하지 못한다면, 주식 시장 버블뿐 아니라 교육받은 인력의 가뭄도 겪게 될 것

- 기술적 배경이 없는 투자자들은 “AI가 이미 코딩의 전부를 대체했다”고 오해하고, 시니어 개발자들은 여전히 AI 도구를 일상 업무에 통합할 유용한 방법을 찾지 못함

- AI 리터러시가 낮은 사람일수록 AI를 더 많이 사용하는 경향이 있어 우려됨

- 궁극적인 ‘Dunning-Kruger(더닝-크루거)’ 함정으로 작용 - 지식이 부족한 사람이 오히려 자신이 잘 안다고 착각하는 현상

- 학습자들이 "AI가 이미 알고 있으니" 자기계발이 무의미하다고 결론 내림

AI는 학습에 유익한가?

- 여전히 코딩 배우기에 대한 사회적 관심도 높음

- AI가 학습에 유익할 수도 있지만, 두 가지 구조적 문제가 존재함

- 첫 번째: 아첨(sycophant) 문제

- AI 챗봇은 질문자 의견에 과도하게 동조하는 경향이 있음

- “ROAS(광고수익률)에 대해” 채팅해보면, 같은 데이터를 놓고 질문 방향에 따라 정반대 결론을 내며, 모두 전문가적 어조로 확신 있게 답함

- 이는 학습자에게 검증, 비판적 사고, 오류 지적을 경험할 기회를 박탈함

- 전문가에게 묻는 이유는 우리가 틀렸을 때 알려주기 위함

- IRC 채팅이나 Stack Overflow는 이를 잘 수행했음(아마도 너무 잘)

- LLM(대형언어모델) 챗봇은 기존 학습자의 근본적 오해를 바로잡지 못하는 경향이 강함

- 현재 학생들은 LLM과 편안한 대화를 나누며 필요한 것이 아닌 듣고 싶은 것을 듣게 됨

- 두 번째 문제: 학습자는 실질적 ‘의견’을 원함

- AI는 지나치게 균형 잡힌 입장을 제시함

- "어떤 사람들은 X라고 생각하고 어떤 사람들은 Y라고 생각한다"

- 학습자가 어느 쪽에 동의할지 결정하기 더 어려워짐

- "자본주의자 역할" 또는 "마르크스주의 혁명가 역할"을 하도록 프롬프트했지만 만족스러운 결과를 얻지 못함

- 학습자는 실제 경험에서 나온 의견과 논평을 듣고 싶어함

- DHH가 Turbo에서 TypeScript를 제거한 이유

- Anders Hejlsberg가 TypeScript가 JavaScript 개발자에게 해결해주는 것

- 각 저자의 편견과 맥락이 명확히 드러나는 실제 의견을 통해 미묘한 멘탈 모델이 형성됨

- LLM 특유의 중립적·조심스러운 답변은 실제 지식 내면화에 방해가 됨

- AI는 지나치게 균형 잡힌 입장을 제시함

AI가 학습에 진짜 도움 되는 경우

- AI는 올바르게 사용하면 학습을 위한 놀라운 도구임

- 코딩을 배우기에 이보다 쉬운 시대는 없었음

- Boot.dev의 Boots(AI 교육 보조 도구) 사례

- 학생들이 인스트럭터 솔루션(이상적인 정답)을 보는 것보다 AI 튜터(Boots)와 채팅하는 것을 거의 4배 더 많이 사용

- Boots는 일반 챗봇과 달리 다음 방식으로 학습에 도움 줌

- 답을 직접 알려주지 않도록 사전 프롬프팅됨

- 소크라테스식 방법을 사용하여 학생이 문제에 대해 더 깊이 생각하도록 유도

- 강사의 솔루션에 접근할 수 있어 정답에 대한 환각 가능성이 훨씬 낮음

- 즐거운 캐릭터성 부여(마법사 곰)

바이브 코딩 지옥 탈출법

- 결론적으로, 튜토리얼 지옥이든 바이브 지옥이든, ‘남에게 맡기지 말고 스스로 해보는 경험’ 이 매우 중요함

- 튜토리얼 지옥: 비디오 끄고 직접 코드 작성 경험 쌓기

- 바이브 지옥: 코파일럿 등 AI 자동완성 꺼두고, 스스로 문제 해결 경험 쌓기

- 피해야 할 것:

- 에디터 내 AI 자동완성

- 에이전트 모드 및 AI 자동화 도구로 프로젝트 처리

- 활용할 수 있는 것:

- 질문에 답하고, 개념을 설명하고, 예제를 제공하는 챗봇

- 소크라테스식 방법으로 질문하도록 유도하는 시스템 프롬프트를 통해 깊은 사고 촉진

- 주장을 할 때 출처를 인용하고 문서에 링크하도록 요청하는 시스템 프롬프트로 정보 신뢰성 확보

핵심 원칙

- 학습은 반드시 불편해야 함

- 튜토리얼 지옥은 다른 사람이 코딩하는 것을 보면서 불편함을 피할 수 있게 해줌

- 바이브 코딩 지옥은 AI가 코드를 작성하게 하면서 불편함을 피할 수 있게 해줌

- 진짜 학습은 막히고, 좌절하고, 가장 중요하게는 문제 해결을 강제당할 때 일어남

- 이것이 인간의 신경망이 재배선되는 방식

- "학습은 어려워야 한다"는 개념을 지나치게 확대하면 형편없는 교육 설계의 변명이 될 수 있음

- 저자는 이를 옹호하지 않음

- 개념이 최선의 방식으로 설명되더라도, 학생은 여전히 그것과 씨름하고 새로운 맥락에서 스스로 사용해야 진정으로 이해할 수 있음

- 진짜 학습 은 직접 막히고, 좌절하고, 자신의 힘으로 돌파하는 과정에서 완성됨

'프로그래밍' 카테고리의 다른 글

| PHP 8.5: The Version That Will Actually Makes Life Easier (0) | 2025.10.17 |

|---|---|

| 마인크래프트 하면서 영어 배운다…알레프랩 와이콤비네이터에 ‘낙점’ (0) | 2025.10.17 |

| 구글도 ‘어디서나 근무’ 이젠 안돼…회사로 나오라는 빅테크 (0) | 2025.10.13 |

| 왜 우리는 악순환에 빠지는가 (behavioralscientist.org) (0) | 2025.09.22 |

| Being good isn’t enough, 잘하는 것만으로는 충분하지 않음 (0) | 2025.09.17 |

코딩 없이 배우는 프롬프트 엔지니어링: 누구나 할 수 있는 생성형 AI 활용법

코딩 없이 배우는 프롬프트 엔지니어링: 누구나 할 수 있는 생성형 AI 활용법

https://wikidocs.net/book/17625

코딩 없이 배우는 프롬프트 엔지니어링: 누구나 할 수 있는 생성형 AI 활용법

# 코딩 없이 배우는 프롬프트 엔지니어링 ## 누구나 쉽게 시작할 수 있는 생성형 AI 활용법 안녕하세요. 이 책은 생성형 AI, 특히 ChatGPT와 같은 대형…

wikidocs.net

누구나 쉽게 시작할 수 있는 생성형 AI 활용법

안녕하세요.

이 책은 생성형 AI, 특히 ChatGPT와 같은 대형언어모델(LLM)을 보다 실용적이고 효과적으로 활용하고자 하는 분들을 위한 안내서입니다.

코딩 지식이 전혀 없어도 괜찮습니다.

이 책에서는 기술적인 배경보다 프롬프트를 잘 쓰는 법, 즉 AI에게 질문하고 지시하는 기술에 집중합니다.

직관적이고 반복 가능한 프롬프트 작성법을 배워 업무와 일상에 바로 적용할 수 있도록 도와드립니다.

📌 이 책을 통해 배우실 수 있는 것들

- 프롬프트 엔지니어링의 개념과 중요성 이해

- 좋은 프롬프트의 구조와 작성법

- 다양한 실전 예제를 통한 프롬프트 실습

- 마케팅, 글쓰기, 교육, 회의 정리 등 실무에 바로 적용 가능한 템플릿

- 프롬프트 실험법과 튜닝 요령을 통해 더 나은 결과 얻기

🎯 이런 분들께 추천드립니다

- ChatGPT는 써봤지만 어떻게 써야 할지 감이 안 잡히는 분

- 프롬프트만 잘 써도 일을 더 잘하고 싶은 직장인

- 창작, 기획, 교육 등 비개발 직군에서 AI를 활용하고 싶은 분

- 코딩 없이도 AI 시대에 주도적으로 참여하고 싶은 모든 분들

✨ 책의 특징

- 100% 비전공자 중심 구성

- 실제 업무에 적용할 수 있는 프롬프트 템플릿 제공

- 다양한 실험과 사례를 통한 직접 해보는 연습 기회

'프로그래밍 > AI_DeepLearning' 카테고리의 다른 글

| 학생 숨은 표정 읽고 한마디 “어려우면 도와줄게”…AI가 부른 교육혁명 (0) | 2026.01.05 |

|---|---|

| [AI] 5W1H를 활용한 프롬프트 설계 방법 📝 (0) | 2025.09.26 |

| AI 파일럿의 95%가 실패하는 이유 — 그리고 당신이 피하는 법 (every.to) (0) | 2025.09.15 |

| [AI] 오픈AI '10년 판짜기'의 여정 (0) | 2025.09.08 |

| [AI] 커서(Cursor)와 바이브코딩(Vibe Coding) (1) | 2025.07.04 |

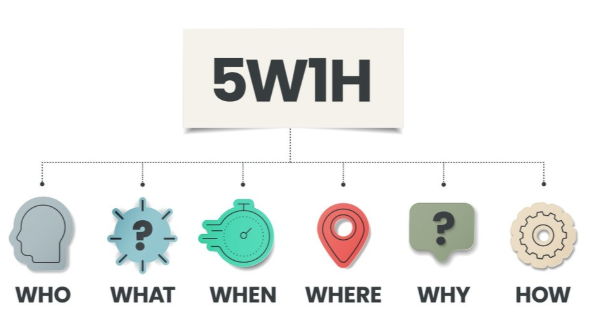

[AI] 5W1H를 활용한 프롬프트 설계 방법 📝

[AI] 5W1H를 활용한 프롬프트 설계 방법 📝

프롬프트 엔지니어링 가이드 : https://www.promptingguide.ai/kr

5W1H는 AI에게 명확한 컨텍스트와 목표를 제공하여 원하는 결과를 정확하게 얻기 위한 훌륭한 프레임워크입니다.

5W1H는 누가(Who), 무엇을(What), 언제(When), 어디서(Where), 왜(Why), 어떻게(How) 요소를 채워 프롬프트를 구체적으로 작성하는 방법입니다. 이는 모델에게 제공하는 정보와 맥락을 명확히 하여, AI가 보다 정확한 답변을 제공할 수 있도록 합니다.

5W1H를 활용한 프롬프트 설계 방법 📝

5W1H(누가, 무엇을, 언제, 어디서, 왜, 어떻게) 각 요소에 맞춰 AI에게 정보를 제공하면, AI는 사용자의 의도를 훨씬 더 잘 파악하고 정확한 결과물을 생성합니다.

1. Who (누가) - 역할 지정

AI에게 특정 전문가의 **역할(Persona)**을 부여하여 답변의 관점과 깊이를 정합니다.

- Before: 쿼리 만들어줘

- After: 너는 20년차 MSSQL 데이터베이스 관리자(DBA)야.

2. What (무엇을) - 작업 정의

수행해야 할 **핵심 작업(Task)**을 명확하고 구체적으로 지시합니다.

- Before: 직원 데이터 좀 줘

- After: 2024년도에 입사한 서울 지역 근무자들의 이름, 부서, 입사일을 조회하는 쿼리를 만들어줘.

3. When (언제) - 시점 명시

데이터의 시간적 범위를 지정하여 원하는 기간의 정보만 필터링하도록 합니다.

- Before: 판매 실적 알려줘

- After: 2025년 3분기(7월 1일부터 9월 30일까지)의 일일 판매 총액을 알려줘.

4. Where (어디서) - 환경/출처 지정

작업이 이루어져야 할 **환경이나 데이터의 출처(Source)**를 알려줍니다. 테이블이나 데이터베이스 이름을 명시하는 것이 대표적입니다.

- Before: 직원 테이블에서 찾아봐

- After: SalesDB 데이터베이스의 Employees 테이블과 Departments 테이블을 사용해서 찾아봐.

5. Why (왜) - 목적 설명

이 작업을 수행하는 **궁극적인 목적(Purpose)**을 설명하여 AI가 더 나은 해결책을 제안하도록 유도합니다.

- Before: 오래된 주문 찾아줘

- After: 장기 미사용 고객에게 마케팅 이메일을 보내기 위해, 최근 1년 동안 구매 기록이 없는 고객 목록을 추출하고 싶어.

6. How (어떻게) - 형식/조건 지정

결과물의 형식(Format)이나 스타일, 따라야 할 특정 조건을 구체적으로 요구합니다.

- Before: 쿼리 짜줘

- After: CTE(Common Table Expression)를 사용해서 쿼리를 작성해 주고, 각 코드 줄마다 한국어로 주석을 상세하게 달아줘. 결과는 Markdown 테이블 형식으로 보여줘.

'프로그래밍 > AI_DeepLearning' 카테고리의 다른 글

| 학생 숨은 표정 읽고 한마디 “어려우면 도와줄게”…AI가 부른 교육혁명 (0) | 2026.01.05 |

|---|---|

| 코딩 없이 배우는 프롬프트 엔지니어링: 누구나 할 수 있는 생성형 AI 활용법 (0) | 2025.10.02 |

| AI 파일럿의 95%가 실패하는 이유 — 그리고 당신이 피하는 법 (every.to) (0) | 2025.09.15 |

| [AI] 오픈AI '10년 판짜기'의 여정 (0) | 2025.09.08 |

| [AI] 커서(Cursor)와 바이브코딩(Vibe Coding) (1) | 2025.07.04 |